近日,南京邮电大学电子与光学工程学院、柔性电子(未来技术)学院黄丽亚教授、孙科学教授团队在视障辅助导航领域取得新的研究成果,提出一种基于立体视觉与空间注意力机制的高精度障碍检测算法 SGBM_YOLO。相关研究成果以 “SGBM_YOLO: A High-Precision Obstacle Detection Algorithm for Assistive Navigation Based on Stereo Vision and Spatial Attention Mechanism” 为题,发表于中科院Top期刊《Applied Soft Computing》。

视障群体的自主出行问题一直是社会关注的焦点,我国约有 1800 万盲人,日常出行面临诸多障碍。现有辅助导航技术中,传统YOLO 系列算法在小目标检测精度、尺度变化适应性及深度信息融合方面存在明显局限,且主流数据集缺乏对视障导航关键元素的全面覆盖,难以满足复杂场景下的实用需求。如何实现高精度、实时性的障碍检测与距离测量,成为提升视障辅助设备性能的核心挑战。

针对这一难题,研究团队以YOLOv5 为基础框架,进行了多维度技术创新:引入空间深度卷积(SPDConv),在卷积过程中实现通道维度无损失,结合小目标预测头显著提升小障碍物检测能力;设计改进型空间金字塔池化模块(SPPFCSPC),扩大感受野并增强特征融合,提升算法对不同尺度目标的适应性;集成高效通道注意力机制(ECA),在不增加计算复杂度的前提下,减少特征维度变化导致的信息丢失,增强模型对复杂环境的适应能力。

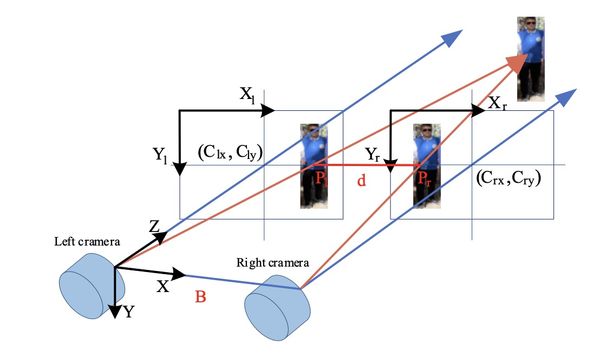

为解决数据集瓶颈,团队构建了BlindData 数据集,涵盖人员、自行车、汽车、斑马线、红绿灯、盲道、坑洼等8 类视障导航关键目标,同时融入深度信息标注,为算法验证提供了贴近真实场景的基准数据。在此基础上,算法进一步融合半全局匹配(SGBM)与双目视觉测距技术,实现了障碍检测与深度测量的有机结合(图1)。

图1 双目深度测距示意图

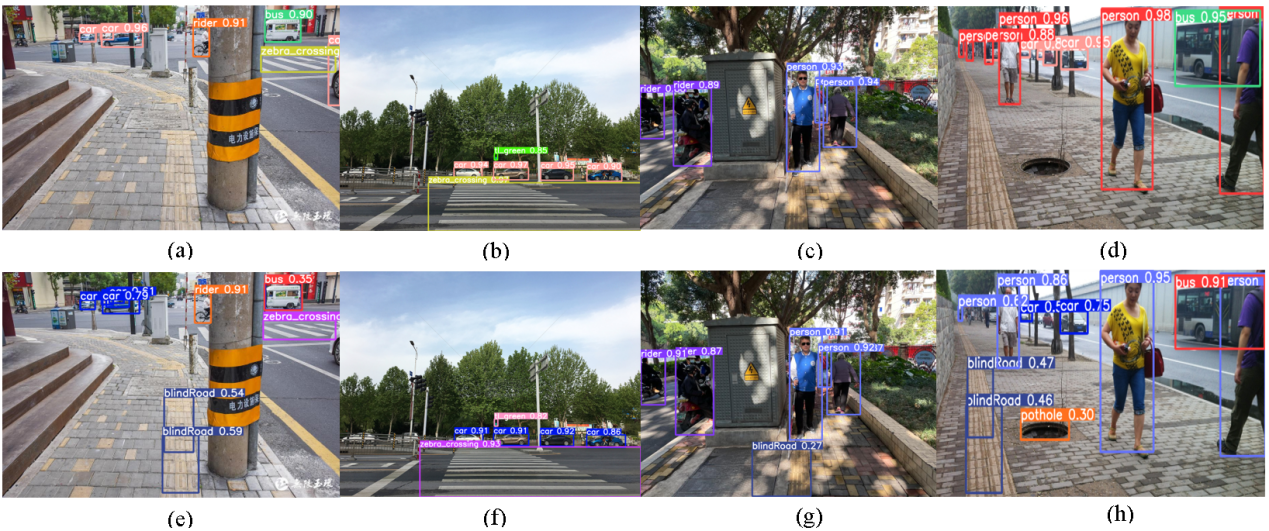

实验结果表明,SGBM_YOLO 算法性能优势显著:在BlindData 数据集上,平均精度均值(mAP)达到93.0%,较YOLOv5m 和YOLOv8m 分别提升 3.9% 和4.2%;在 10 米测距范围内,深度测量误差仅为3.2%,远优于传统方法。在COCO 数据集测试中,该算法对小目标检测的平均精度(AP_S)提升2.35%,充分验证了其在通用场景下的适用性。尤其在盲道识别、坑洼检测等视障导航核心场景中,算法展现出优异的检测精度和鲁棒性(图2)。

图2 Yolov5 与所提方法在验证集中的检测效果对比。

(a)(b)(c)(d)为 Yolov5m 检测效果图;

(e)(f)(g)(h)为 SGBM_YOLO 检测效果图

该研究形成了 “数据集构建-算法创新-性能验证” 的完整技术链条,提出的SGBM_YOLO 算法有效突破了传统辅助导航技术的性能瓶颈,为视障辅助设备的智能化升级提供了全新解决方案。其兼具高精度与实时性的特点,有望推动视障辅助导航技术从实验室走向工程化应用,显著提升视障群体的出行安全性与自主性,对推进智能物联网技术在特殊群体关怀领域的应用具有重要意义。

论文信息:SGBM_YOLO: A High-Precision Obstacle Detection Algorithm for Assistive Navigation Based on Stereo Vision and Spatial Attention Mechanism

Guoqi Heng, Chenyao Luo, Kexue Sun*, Shuo Huang, Liya Huang

链接:https://doi.org/10.1016/j.asoc.2025.114144

(撰稿:孙科学 编辑:徐伟 审核:谌静)